}

}

本教程适用于AI开发者、算法工程师、AI研究者以及大模型爱好者。无论您是初学者还是经验丰富的技术人员,都可以通过本教程系统地掌握大模型技术,并将其应用于实际项目中。

课程概述:

深入了解TRansformEr预训练语言模型的底层架构。学习Ollama的安装配置及DeePSeek大模型的部署流程。掌握指令微调技术和人类反馈强化学习(RLHF+PPO)算法的应用,并通过具体案例提升在实际场景中的应用能力。

课程亮点:

技术本源深度挖掘:解析Transformer预训练语言模型的核心架构,比较不同技术路径的优劣,掌握从基础构建到功能实现的大模型逻辑。

实战能力层层递进:系统学习精准指令的编写方法,激发大模型潜力。深入探讨马尔科夫决策过程(MDP)及PPO算法的应用,实现更贴合需求的输出效果。

前沿趋势精准把握:解析GPT智能涌现原理,理解上下文学习能力如何驱动模型性能提升。前瞻通用人工智能(AGI)的发展方向。

课程内容模块:

1. 基础理论:介绍大模型的基本概念与技术框架。

2. 实践操作:通过具体的开发流程和代码示例进行练习,包括DeepSeek大模型的训练微调、本地部署与管理、人类反馈强化学习等。

3. 高级应用:探讨前沿技术和应用场景,如模型文件全解析与实战指南、本地运行DeepSeek-R1满血版大模型等。

课程特色:

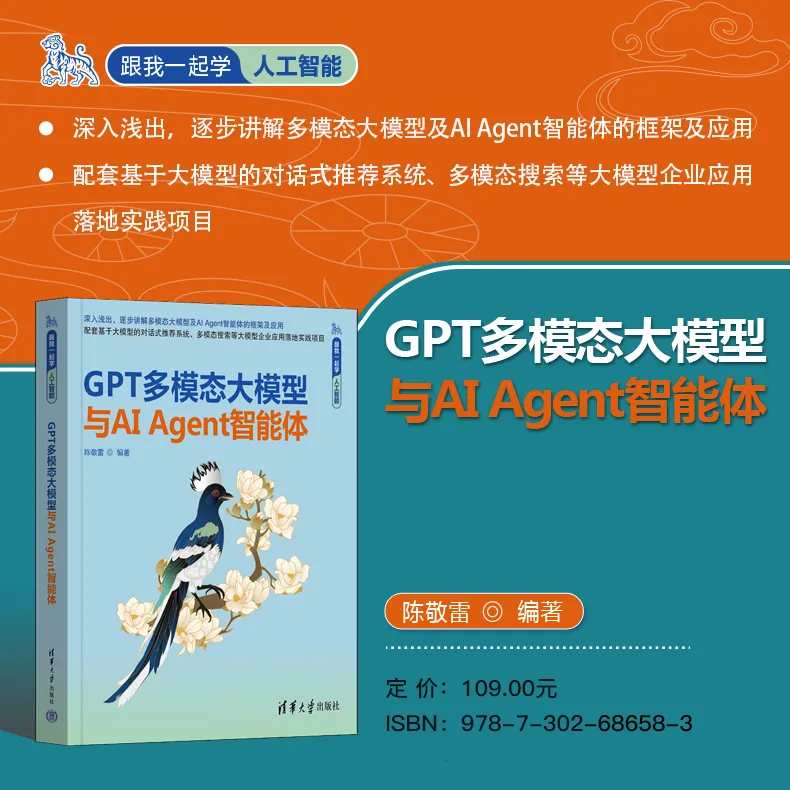

本视频教程由陈敬雷老师主讲,结合实践视频内容和配套教材《GPT多模态大模型与AI Agent智能体》,帮助学习者从静态理论和动态实战两方面高效掌握知识体系。

详细课程列表:

1-1 UnsLoth:革新DeepSeek大模型训练微调开发工具.mp4

1-2 DeepSeek训练微调代码实践.mp4

1-3 DeepSeek-R1:模型文件全解析与实战指南.mp4

1-4 本地运行DeepSeek-R1满血版大模型.mp4

1-5 Ollama 框架详解:本地部署 DeepSeek 大模型实战指南.mp4

以及其他关于PPO强化学习算法、人类反馈强化学习对齐、AI智能体Dify集成等的课程视频。